Contáctenos.

NVIDIA: mejor rendimiento para la IA.

Para aprovechar las ventajas que ofrece la inteligencia artificial, se necesita una gran capacidad de cálculo. El potente sistema NVIDIA® DGX™ cumple estos requisitos. Se basa en la plataforma de alto rendimiento de GPU NVIDIA. Lo que lo hace especial es que NVIDIA DGX ofrece a las empresas un software optimizado para la GPU y una gestión simplificada en un sistema compacto.

Las ventajas de DGX Station y DGX Server:

Software y hardware integrados.

Basado en la tecnología NVIDIA™ Tensor Core para acelerar la IA y HPC.

Entrenamiento de deep learning, inferencia y aceleración de análisis en un solo sistema.

Rendimiento inigualable para acelerar las iteraciones y la innovación.

NVIDIA DGX™ A100 es el sistema universal para todas las cargas de trabajo de IA y ofrece una densidad de cálculo, rendimiento y flexibilidad sin precedentes en el primer sistema de IA de 5 petaFLOPS del mundo. NVIDIA DGX A100 cuenta con el acelerador más avanzado del mundo, la GPU NVIDIA A100 Tensor Core, que permite a las organizaciones consolidar el entrenamiento, la inferencia y el análisis en una infraestructura de IA unificada y fácil de implementar con acceso directo a los expertos en IA de NVIDIA.

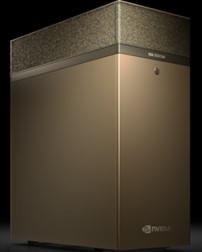

NVIDIA® DGX Station A100 es un sistema compacto del tamaño de una estación de trabajo que ofrece las últimas tecnologías, una rápida implementación y una capacidad de cálculo local increíble. Para asistirle durante su trabajo, se ha integrado un sistema de refrigeración silencioso y una serie de herramientas para acelerar el desarrollo.

Hay un procesador que es perfecto para la inteligencia artificial: La NVIDIA® A100 ofrece una aceleración sin precedentes a cualquier escala en el entrenamiento e inferencia de deep learning, el análisis de datos y la HPC.

Con los núcleos Tensor de tercera generación, la nueva arquitectura Ampere permite multiplicar por 20 el rendimiento en el entorno de la IA, mientras que la nueva función de GPU multiinstancia (MIG) permite y optimiza la distribución de la carga de trabajo en hasta siete instancias, lo que permite a los equipos de ciencia de datos trabajar con la mayor eficiencia posible.

La NVIDIA® T4 es un todoterreno en un factor de forma compacto. Este acelerador aporta una densidad y una flexibilidad muy elevadas. Está optimizada para la inferencia de deep learning y es un complemento ideal para los sistemas de entrenamiento de deep learning.

En lo que respecta a los gráficos, la T4 ofrece una experiencia de usuario nativa para escritorios virtuales de oficina, así como para estaciones de trabajo virtuales del segmento CAD de gama media.

Hoy en día, para que las estaciones de trabajo ofrezcan el mejor rendimiento posible, la mejor opción es la NVIDIA® A40. Este acelerador ofrece suficiente rendimiento para aplicaciones muy exigentes, como CAD, simulaciones y realidad virtual, e incluso permite el renderizado en tiempo real para obtener un resultado fotorrealista.

Choose the right NVIDIA Data Center GPU

Workload

| Description | NVIDIA A100 SXM4 | NVIDIA A100 PCIe | NVIDIA T4 | NVIDIA A40 |

| World's Most Powerful Data Center GPU | Versatile Data Center GPU for Mainstream Computing | World's Most Powerful Data Center GPU for Visual Computing | ||

Deep Learning Training | For the absolute fastest model training time | 8-16 GPUs | 4-8 GPUs |

|

|

Deep Learning Inference | For batch and real-time inference | 1 GPU w/ MIG | 1 GPU w/ MIG | 1 GPU |

|

HPC / AI | For scientific computing centers and higher ed and research institutions | 4 GPUs with MIG for | 1-4 GPUs with MIG for |

|

|

Render Farms | For batch and real-time rendering |

|

|

| 4-8 GPUs |

Graphics | For the best graphics performance on professional virtual workstations |

|

| 2–8 GPUs for mid-range | 4-8 GPUs for highest |

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 1-4 with MIG for compute intensive | 1-4 GPUs with MIG for | 4-8 GPUs for balanced | 2-4 GPUs for graphics |

Edge Acceleration | Edge solutions with differing use cases and location |

| 1-2 GPU with MIG | 1-8 GPUs for inference | 2-4 GPUs for graphics |

Workload

| Description | NVIDIA A100 SXM4 | NVIDIA A100 PCIe |

| World's Most Powerful Data Center GPU | ||

Deep Learning Training | For the absolute fastest model training time | 8-16 GPUs | 4-8 GPUs |

Deep Learning Inference | For batch and real-time inference | 1 GPU w/ MIG | 1 GPU w/ MIG |

HPC / AI | For scientific computing centers and higher ed and research institutions | 4 GPUs with MIG for | 1-4 GPUs with MIG for |

Render Farms | For batch and real-time rendering |

|

|

Graphics | For the best graphics performance on professional virtual workstations |

|

|

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 1-4 with MIG for compute intensive | 1-4 GPUs with MIG for |

Edge Acceleration | Edge solutions with differing use cases and location |

| 1-2 GPU with MIG |

Workload

| Description | NVIDIA T4 | NVIDIA A40 |

| Versatile Data Center GPU for Mainstream Computing | World's Most Powerful Data Center GPU for Visual Computing | |

Deep Learning Training | For the absolute fastest model training time |

|

|

Deep Learning Inference | For batch and real-time inference | 1 GPU |

|

HPC / AI | For scientific computing centers and higher ed and research institutions |

|

|

Render Farms | For batch and real-time rendering |

| 4-8 GPUs |

Graphics | For the best graphics performance on professional virtual workstations | 2–8 GPUs for mid-range | 4-8 GPUs for highest |

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 4-8 GPUs for balanced | 2-4 GPUs for graphics |

Edge Acceleration | Edge solutions with differing use cases and location | 1-8 GPUs for inference | 2-4 GPUs for graphics |

* Campos obligatorios

Acceda al enlace de nuestra declaración de privacidad. Aquí le proporcionamos información detallada acerca de nuestro procesamiento de datos y sus derechos de protección de datos.