Prosimy o kontakt.

NVIDIA – najlepsza wydajność dla SI.

Aby czerpać korzyści ze sztucznej inteligencji, wymagana jest duża moc obliczeniowa. Produktywnym systemem, który spełnia takie wymagania, jest NVIDIA® DGX™. System ten opiera się na wysokowydajnej platformie NVIDIA GPU. NVIDIA DGX oferuje firmom oprogramowanie zoptymalizowane do GPU i ułatwione zarządzanie – to wszystko w jednym kompaktowym systemie.

Korzyści płynące z zastosowania stacji DGX i serwera DGX:

Zintegrowane oprogramowanie i sprzęt.

Oparty na technologii NVIDIA ™-Tensor Core do przyspieszenia SI i HPC.

Trening głębokiego uczenia się, inferencja i przyspieszanie analizy w jednym systemie.

Niezrównana wydajność dla szybszych iteracji i innowacji.

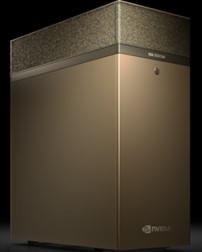

NVIDIA DGX™ A100 jest uniwersalnym systemem do wszystkich obciążeń SI i oferuje niezrównaną gęstość, wydajność i elastyczność w pierwszym na świecie systemie SI 5 petaFLOPS. NVIDIA DGX A100 posiada najbardziej zaawansowany akcelerator na świecie, procesor graficzny NVIDIA A100 Tensor Core, za pomocą którego firmy mogą konsolidować szkolenia, kalkulacje, analizy w ujednoliconą i łatwą do wdrożenia infrastrukturę SI z bezpośrednim kontaktem do eksperta.

NVIDIA® DGX Station A100 to kompaktowy system w formacie stacji roboczej, oferujący najnowsze technologie, szybkie udostępnianie i niewiarygodną lokalną moc obliczeniową. Zintegrowany niezwykle cichy system chłodzenia i dostępne narzędzia gwarantują produktywną pracę.

Do zastosowania sztucznej inteligencji odpowiedni jest szczególnie jeden procesor. NVIDIA® A100 oferuje bezprecedensowe przyspieszenie w dowolnej skali w obszarach treningu głębokiego uczenia, inferencji głębokiego uczenia się, analizy danych i HPC.

Dzięki Tensor jednostce obliczeniowej trzeciej generacji nowa architektura Ampere umożliwia 20-krotny wzrost wydajności w środowisku SI, podczas gdy nowa funkcja Multi-Instance-GPU (MIG) umożliwia i optymalizuje rozkład obciążenia do siedmiu instancji, co oznacza, że Data Science Teams może pracować wydajniej.

NVIDIA® T4 NVIDIA® T4 jest wszechstronnym urządzeniem w kompaktowej obudowie. Ten akcelerator ma bardzo dużą gęstość i elastyczność. Zoptymalizowany pod kątem inferencji głębokiego uczenia się, a zatem jest idealnym dodatkiem do systemów Deep Learning Training.

W obszarze graficznym T4 zapewnia natywne środowisko użytkownika dla wirtualnych pulpitów w obszarze biurowym, a także dla wirtualnych stacji roboczych w środkowym segmencie CAD.

Aby zapewnić najlepszą możliwą wydajność wirtualnych stacji roboczych, NVIDIA® A40 jest aktualnie najlepszym wyborem. Ten akcelerator zapewnia wystarczającą moc dla bardzo wymagających aplikacji, takich jak CAD, symulacje, VR, a nawet umożliwia renderowanie w czasie rzeczywistym w celu uzyskania fotorealistycznych rezultatów.

Wybierz odpowiedni procesor NVIDIA Data Center.

Workload

| Description | NVIDIA A100 SXM4 | NVIDIA A100 PCIe | NVIDIA T4 | NVIDIA A40 |

| World's Most Powerful Data Center GPU | Versatile Data Center GPU for Mainstream Computing | World's Most Powerful Data Center GPU for Visual Computing | ||

Deep Learning Training | For the absolute fastest model training time | 8-16 GPUs | 4-8 GPUs |

|

|

Deep Learning Inference | For batch and real-time inference | 1 GPU w/ MIG | 1 GPU w/ MIG | 1 GPU |

|

HPC / AI | For scientific computing centers and higher ed and research institutions | 4 GPUs with MIG for | 1-4 GPUs with MIG for |

|

|

Render Farms | For batch and real-time rendering |

|

|

| 4-8 GPUs |

Graphics | For the best graphics performance on professional virtual workstations |

|

| 2–8 GPUs for mid-range | 4-8 GPUs for highest |

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 1-4 with MIG for compute intensive | 1-4 GPUs with MIG for | 4-8 GPUs for balanced | 2-4 GPUs for graphics |

Edge Acceleration | Edge solutions with differing use cases and location |

| 1-2 GPU with MIG | 1-8 GPUs for inference | 2-4 GPUs for graphics |

Workload

| Description | NVIDIA A100 SXM4 | NVIDIA A100 PCIe |

| World's Most Powerful Data Center GPU | ||

Deep Learning Training | For the absolute fastest model training time | 8-16 GPUs | 4-8 GPUs |

Deep Learning Inference | For batch and real-time inference | 1 GPU w/ MIG | 1 GPU w/ MIG |

HPC / AI | For scientific computing centers and higher ed and research institutions | 4 GPUs with MIG for | 1-4 GPUs with MIG for |

Render Farms | For batch and real-time rendering |

|

|

Graphics | For the best graphics performance on professional virtual workstations |

|

|

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 1-4 with MIG for compute intensive | 1-4 GPUs with MIG for |

Edge Acceleration | Edge solutions with differing use cases and location |

| 1-2 GPU with MIG |

Workload

| Description | NVIDIA T4 | NVIDIA A40 |

| Versatile Data Center GPU for Mainstream Computing | World's Most Powerful Data Center GPU for Visual Computing | |

Deep Learning Training | For the absolute fastest model training time |

|

|

Deep Learning Inference | For batch and real-time inference | 1 GPU |

|

HPC / AI | For scientific computing centers and higher ed and research institutions |

|

|

Render Farms | For batch and real-time rendering |

| 4-8 GPUs |

Graphics | For the best graphics performance on professional virtual workstations | 2–8 GPUs for mid-range | 4-8 GPUs for highest |

Enterprise Acceleration | Mixed Workloads – Graphics, ML, DL, analytics, training, inference | 4-8 GPUs for balanced | 2-4 GPUs for graphics |

Edge Acceleration | Edge solutions with differing use cases and location | 1-8 GPUs for inference | 2-4 GPUs for graphics |

* pola obowiązkowe

Prosimy o zapoznanie się z naszą polityką prywatności, która szczegółowo informuje Państwa o przetwarzaniu danych i istniejących przepisach, dotyczących ich ochrony.